Ciao e benvenuto alla edizione #42 della EV SEO newsletter, nella quale ho raccolto le novità e i contenuti SEO più interessanti (o almeno quelli che ho trovato tra i tanti che ho letto) delle ultime due settimane.

Agosto 2019 è stato ricco di spunti per la SEO (come ogni periodo nel quale sono in viaggio e mi “distraggo” un attimo) ma anche settembre “non scherza mica” come diciamo qui a Modena. Direi quindi di passare subito al sodo! Buona lettura.

John Mueller parla di “recuperi da major update”

Te l’avevo detto. E ri-detto. E ri-detto un’altra volta: questi “broad/major update” lavorano sulla rilevanza. Questi update lavorano, secondo me, aggiornando sistemi di analisi che hanno bisogno di un “update manuale” come fu Panda ormai diversi anni fa. Facciamo un passo indietro.

Roger Montti ha scritto questo bel riassunto sul Search Engine Journal parlando della risposta che John Mueller, durante un hangout del 3 settembre, ha dato alla seguente domanda:

Sono stato colpito dal core update di Giugno. Ci siamo messi al lavoro sul contenuto di qualità. Quanti mesi dovrò aspettare per vedere una ripresa? Può Googlebot decidere di rimuovere una penalizzazione senza altri core update?

A parte indicare l’errore nel pensare che “Googlebot” prenda decisioni (è “solamente” il software che visita i siti web) Montti trova quattro punti chiave nella risposta di John Mueller, li vorrei analizzare anche io perché sono molto interessanti.

Le pagine che hanno perso traffico non sono penalizzate

Purtroppo la parola “penalizzazione”, soprattutto dopo il massacro del primo Penguin, è usata in modo piuttosto leggero, creando molta confusione.

Come dice Mueller il problema non è legato all’aver violato delle regole/linee guida di Google: il problema è che il sito non è più altrettanto rilevante per SERP o insiemi, anche molto grandi, di SERP. Google ha cambiato idea su cosa rispondere ad un utente che fa una specifica query. Possono cambiare moltissime cose:

- La SERP può diventare da nazionale a locale, con uno stravolgimento cataclismico (l’ho visto in prima persona nel famoso update di agosto 2018);

- La SERP può cambiare come tipologia di risposte servite, ad esempio passando da una lista di pagine pubblicate su siti che fanno informazione ad una SERP fatta di prodotti di ecommerce, o viceversa. Questo magari non totalmente ma cambiando il bilanciamento tra l’una e l’altra cosa;

- La SERP può cambiare come tipologia di attori serviti, passando ad esempio da siti di specifici brand che offrono un servizio ad una serie di listatori multi-brand che offrono il servizio stesso;

A volte il cambiamento avviene in modo così sostanziale e per insiemi così grandi di query e quindi di SERP che il calo risulterà talmente netto e brusco da sembrare una penalizzazione. In realtà il problema è che Google ha cambiato idea. Fermo restando che è sempre una buona idea farsi un’esame di coscienza e usare lo shock subito come slancio per migliorarsi, le opzioni principali per fronteggiare il problema secondo me sono:

- aspettare e vedere se avviene un sovvertimento, un roll-back;

- prendere decisioni molto drastiche andando o, se siamo in grado di analizzarla, ad assecondare la nuova idea di Google, oppure cambiare radicalmente lato business trasformando gli asset rappresentati dai propri contenuti/property web. La fortuna di lavorare sul web è che i contenuti sono asset fluidi, non sono prodotti difficili da trasformare;

NOTA: Alcuni di questi siti con grosse perdite di traffico organico potrebbero aver messo in campo strategie che violano i termini di servizio di Google, e queste violazioni possono essere “perseguite” da Google lo stesso giorno di un core update, ma si tratta di un caso.

I core update riguardano pagine che si posizionano meglio in quanto più rilevanti (o che perdono posizionamento se sono meno rilevanti)

Una cosa che penso purtroppo non sia chiara è che, come dice Mueller, non è il sito che ha sbagliato qualcosa, è Google che ha cambiato idea.

Con idea intendo che per una specifica query Google ha cambiato/tolto/aggiunto/trasformato/dato un valore diverso ai segnali e alle metriche che decidono chi si posizionerà e come per essa. Citando Mueller:

É più che altro una questione del fatto che (dopo l’update) non pensavamo più che queste pagine fossero rilevanti come lo erano prima. Questi cambiamenti possono avvenire nel tempo

Da molto tempo ripeto, ad ogni occasione utile, che questi update, secondo me, semplicemente lanciano o concludono analisi che richiedono:

- o un input umano;

- o un refresh di un qualche database che non può essere aggiornato costantemente per questioni ad esempio di “economia computazionale”;

- oppure richiedono molto tempo per essere svolte in modo massivo e si concludono ciclicamente ogni X settimane;

Le mie sono naturalmente solo ipotesi ma che Google abbia diversi tempi di analisi per segnali/metriche differenti lo trovo lampante nell’esperienza di tutti i giorni.

Citato nel post di Montti, un articolo pubblicato il primo agosto 2019 sul webmaster blog di Google fa un esempio molto chiaro e interessante:

Un modo per comprendere come un core update funzioni è quello di immaginare una lista dei migliori 100 film scritta nel 2015. Qualche anno più tardi, nel 2019, la lista viene aggiornata. Naturalmente cambierà. Qualche nuovo e bellissimo film che prima non esisteva sarà ora un candidato all’inclusione. Potresti anche voler rivalutare alcuni film realizzando che meritano ora un posto più in alto nella lista.

La lista cambierà, e i film che prima erano molto in alto nella classifica e che perdono posizioni non sono brutti film. Semplicemente ci sono film che meritano di stare prima di loro.

Mi rendo conto che a volte, guardando alcune SERP, sia uno scenario difficile da digerire. “Cioè mi stai dicendo che quel sito merita più del mio?“. No, non te lo dico io, lo ha “detto” l’algoritmo. Il problema di fondo è che Google cerca di trattare automaticamente una quantità immane di dati, dando probabilmente una certa priorità agli spazi che faranno guadagnare più soldi agli azionisti. Nel fare questo potrebbe commettere errori ma solo gli umani possono valutarli come tali: l’algoritmo ha preso le decisioni al meglio delle sue possibilità. Poi certamente possiamo addentrarci in una dietrologia infinita ma preferirei farlo magari in un’altra occasione.

Non devi aspettare il prossimo update per riprenderti

Se il problema è che il sito non è più rilevante per le query e, dopo uno studio delle query stesse, il sito stesso viene “adattato”, questo potrà tornare a posizionarsi non appena Google avrà compiuto le analisi “canoniche” del caso notando questo cambiamento. Questo periodo di tempo non deve per forza coincidere con il palesarsi di un nuovo update: i casi di “recupero”, come giustamente dice Montti, sono il risultato di un “passo indietro” di Google che affina ciò che è stato cambiato durante l’update.

Google funziona a threshold, letteralmente “soglie” entro le quali misura, calcolando il “voto” relativo al posizionamento in modo fattoriale (molti non ci pensano ma Google funziona non per addizione ma per moltiplicazione, con diverse forti implicazioni che non ho tempo di disquisire in questa sede), se si è “dentro o fuori” e se si è “prima o dopo” altri documenti che concorrono per una specifica query su di una specifica SERP.

Cambiando i nostri contenuti, la distribuzione del PageRank, l’apporto in entrata del PageRank, la struttura delle informazioni etc. etc. ci muoviamo all’interno di queste soglie. Proprio perché non si tratta di penalizzazione la possibilità di “riprendersi” c’è senza che ci sia bisogno di un nuovo core update. Citando Mueller:

L’intera Internet cambia nel tempo e con essa i nostri risultati di ricerca, i quali essenzialmente cambiano giorno per giorno e possono allo stesso modo migliorare giorno per giorno.

Quindi se state effettivamente migliorando in modo significativo il vostro sito (per quanto concerne il giudizio di Google non il vostro N.D. Emanuele) dovreste notare dei piccoli cambiamenti nel tempo. La questione non è attendere uno specifico cambiamento per avere cambiamenti nel posizionamento.

Generalmente non riguarda lo spam

Mueller ribadisce più volte che non si tratta di penalizzazioni e menziona specificamente lo “web spam“. Vorrei fare una riflessione proprio su questo punto: allo stato attuale delle cose non penso che Google abbia bisogno di sistemi pesanti e lenti come un update lanciati ogni X mesi per eliminare lo spam dalle SERP.

Google ha passato un periodo di diversi anni dove lo sviluppo si è concentrato nell’affinare i sistemi anti-spam, primo fra tutti Penguin, fino a che non è stato possibile rendere real time e integrati nell’algoritmo core questi strumenti: oggi di fatto sono sempre attivi e vigili (ma non infallibili). Google ha bisogno di fronteggiare velocemente lo spam perché deve rendere meno appetibili le pratiche “churn and burn“, i siti usa e getta basati sulle cosiddette pratiche “black hat” che di fatto abbassano di molto la qualità dei suoi risultati e rischiano di fargli perdere utenti e quindi fatturato dalle ads in SERP.

Da ormai 2/3 anni il focus nello sviluppo sembra, secondo me, essersi spostato sulla rilevanza e sulla qualità delle SERP a livello non più esclusivo, togliendo le “scorie”, ma inclusivo, cercando di selezionare con più efficacia i risultati rilevanti per gli utenti che fanno una specifica query. I sistemi anti-spam non sono perfetti ma sono già piuttosto raffinati, abbastanza da poter incentrare lo sviluppo su altro. Poi magari mi sbaglio, per carità.

Conclusioni

Anche qui se mi leggi da un po’ non troverai grandi sorprese: rincorrere la “verità” sugli update e su specifiche metriche/segnali cambiati è uno spreco del proprio tempo.

Se si è colpiti da un update bisogna correre a studiare le SERP cercando di rilevare cosa sia cambiato nel metro di giudizio di Google. Una volta compreso bisogna decidere come (e se) adattarsi ad esso. Se ti è capitato, buon lavoro.

La penalizzazione per unnatural links e l’esperimento di migrazione link del mitico Dejan SEO

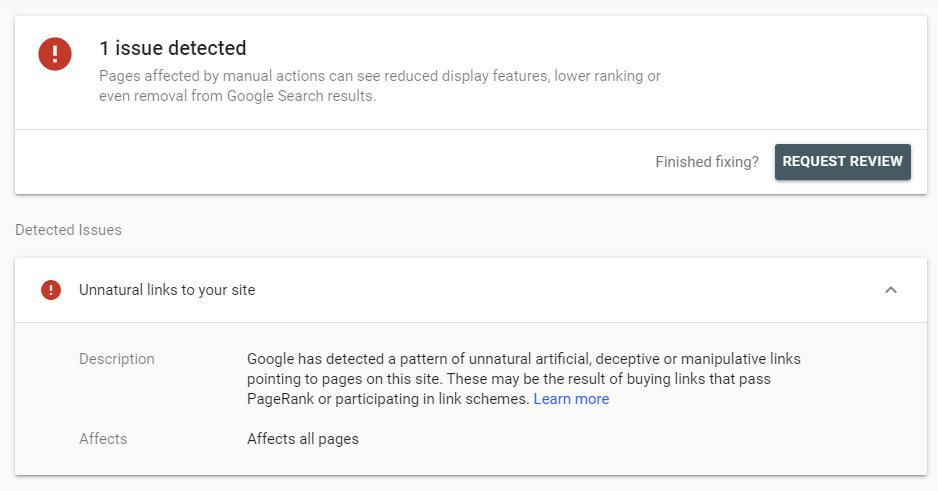

Il buon Dejan Petrovic, storico divulgatore/operatore SEO australiano, si è beccato una bella penalizzazione per “unnatural links” (spoiler: con riconsiderazione accettata dopo una settimana).

Una penalizzazione molto pesante: il dominio non si posizionava più neanche per le chiavi brand, come si vede dallo screenshot qui sopra riguardava tutte le pagine. Petrovic ha dichiarato che “forse ci sono scappati dei link nell’ultimo disavow“, c’è chi vocifera di negative SEO, ma secondo me semplicemente ha esagerato a fare link building.

Detto questo dopo una legittima rosicata Petrovic ha iniziato un esperimento non nuovissimo ma che non ho mai visto descrivere in modo così puntuale: una migrazione di link, della quale descrive in modo approfondito l’evoluzione in questa pagina.

Con migrazione di link intendo l’attività per la quale, cambiando dominio come sta facendo Petrovic, si trasferiscono i link chiedendo alla fonte di cambiare URL sulla quale si punta invece di fare dei semplici 301 (che su alcune pagine sono stati fatti in realtà, ma non trovo un’indicazione chiara), un po’, anche se è un esempio diciamo “tirato”, come fece Aranzulla nel passaggio da HTTP a HTTPS. Questa attività, nel caso di Dejan SEO, è stata secondo me fatta per due principali motivi:

- Pulire il profilo link dalle “scorie” che l’hanno reso tossico: per non perdere l’equity raccolta in tanti anni di attività, nell’impossibilità di fare un semplice 301 e quindi tornare ad avere lo stesso profilo link di basso livello (anche se in realtà potrebbe semplicemente mettere il disavow completo, tecnicamente), chiedendo direttamente alla fonte di cambiare l’URL al quale punta il link si possono, di fatto, selezionare i link che si vogliono includere nel profilo. Questo è molto utile soprattutto se i link tossici li abbiamo fatti direttamente noi, la butto lì;

- Prendere un sacco di link facendo, di fatto, una campagna di digital PR nella quale sono cascato a piedi uniti con il link che ho messo in questa stessa newsletter!

Come dicevo qualche riga fa, la penalizzazione è stata tolta dopo poco più di una settimana a seguito dell’invio di una riconsiderazione: Petrovic segnala di aver indicato come problema a Google la presenza di link provenienti da guest post, borse di studio e sponsorizzazioni, i quali sono stati prontamente inseriti nel disavow (che secondo me serve ESATTAMENTE per queste situazioni, non per pulire in modo preventivo, lo voglio ribadire ancora una volta). Personalmente penso che il buzz (chiacchiericcio) creato nella community SEO abbia aiutato e non poco la velocità con la quale è stata processata la riconsiderazione, un po’ come la giustizia viene “aiutata” quando si finisce sul giornale: è molto triste ma penso che questa esposizione abbia avuto il suo peso.

L’esperimento, comunque, continua. Alcuni punti interessanti:

- Ottima la sua idea di fare una lista pubblica dei link da trasferire, ovvero questa Google Sheet:

- toglie la fatica di controllare il proprio profilo link, migliorando la possibilità che le persone vadano effettivamente a cambiare il target di eventuali backlink verso le properties di Dejan SEO;

- fa discutere i colleghi del profilo link, creando ulteriore buzz;

- fa si che qualcuno possa notare un link presente nel sito di un amico e segnalarglielo, migliorando l’efficacia del processo di migrazione;

- Insomma una bella idea che non richiede particolare impegno (il profilo è stato sicuramente ricontrollato in fase di creazione della riconsiderazione) ma che può portare benefici molto concreti;

- Il dominio nuovo (che non ho ben capito esattamente se fosse “vergine”, forse l’aveva già parcheggiato?) ha visto una pagina indicizzarsi immediatamente dopo l’inserimento di un backlink verso di essa: quando parlo di “link di discovery” intendo proprio queste cose qua (se non l’hai già fatto sentiti la mia serie di podcast sui link, vediamo se ti metto agitazione come successe con alcuni colleghi);

- Nel giro di 5 giorni 489 url sono passate dal vecchio al nuovo dominio senza redirect 301 ma semplicemente spostando i contenuti (cancellandoli sul sito originale) e spostando anche una parte dei backlink direttamente alla fonte, chiedendo di cambiare “alla fonte” il target del link stesso;

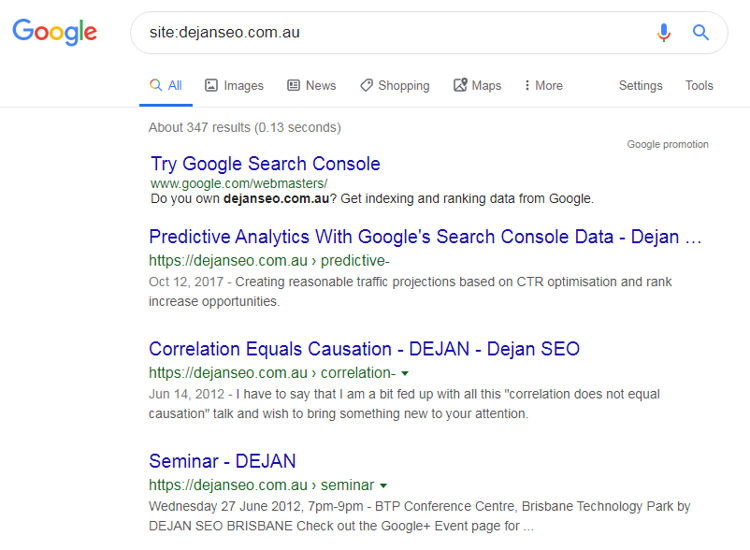

- Il 6 settembre sono apparsi degli strani risultati nella SERP relativa al site: che hanno come URL delle versioni troncate di vecchie pagine del sito, ad esempio l’indirizzo “/predictive-” al posto di “/predictive-analysis/”:

Petrovic dice di non essere sicuro di cosa significhi questa cosa, e sinceramente non lo sono neanche io. Queste URL hanno dei redirect 301 che non so se siano stati fatti prima o dopo l’apparizione di questi risultati. Però è una cosa bizzarra e quindi l’ho voluta inserire!

Petrovic dice di non essere sicuro di cosa significhi questa cosa, e sinceramente non lo sono neanche io. Queste URL hanno dei redirect 301 che non so se siano stati fatti prima o dopo l’apparizione di questi risultati. Però è una cosa bizzarra e quindi l’ho voluta inserire! - Petrovic segnala che Marie Haynes “ha indicato un URL come potenziale causa della penalità” , di fatto un PDF copiato da una università americana e ri-uploadato senza pietà sul sito di Dejan SEO. Petrovic dice di non avere idea del perché l’abbia pubblicato, ma di fatto ha messo in pratica la sua teoria del “canonical switch”: se ci sono più copie di uno stesso documento, quello che viene ospitato presso la fonte più autorevole diventa quello “canonico” per Google in caso di specifiche ricerche del documento stesso. In questo caso il simpatico PDF ha raccolto tanti, tanti link organici e citazioni accademiche, come si può vedere da questa simpatica lista su Google Sheets. Una pratica piuttosto scorretta e che sicuramente può attirare l’attenzione durante un controllo manuale;

- Jenny Halasz e JLH Marketing hanno segnalato a Petrovic che osservando un dominio che aveva “relazioni” con Dejan SEO è possibile avere il sospetto che questi due partecipassero ad uno schema di link, uno dei “trigger pattern based” che probabilmente fa si che venga richiesta dal sistema anti-spam di Google una revisione manuale. Purtroppo non ha voluto dare informazioni specifiche al riguardo;

Che dire: grazie Dejan per la tua disponibilità! Seppur non in totale trasparenza, per motivi tutto sommato comprensibili di autoconservazione, aprire alla community una finestra su questa situazione, oltre a farti raccogliere un sacco di nuovi link per il nuovo dominio, è una buona occasione per riflettere su tantissime questioni, una su tutte di reagire a cose come questa con il raziocinio, muovendosi e “facendo” invece che crucciarsi e lamentarsi.

La SEO e le startup in fase di startup

In una discussione su Twitter Andrew Chen, ex “growth chief” di Uber, ha fatto discutere dichiarando che la SEO è troppo lenta perché le startup possano “affidarvicisi” (rely on).

Traducendo il suo messaggio:

Se sei un CEO/team celebre che può lanciare creando tantissimo rumore nella stampa o puoi creare moltissimo contenuto generato automaticamente non c’è problema. Se non è così (la SEO) dovrebbe essere una attività in background che da i suoi frutti nel terzo o quarto anno per quanto possa essere veloce.

Pur non essendo convintissimo dalle sue stime in termini di anni (secondo me si possono avere risultati degni di nota e soprattutto significativi a livello di durata già dopo 18 mesi con i dovuti investimenti) sono d’accordo con lui che se, come spesso succede, quello che serve è una crescita esplosiva la SEO non è un investimento ottimale per le startup in fase appunto di startup (detta così fa un po’ ridere).

La SEO è lenta, incerta e molto costosa in termini di tempo e/o di denaro… ma come faccio ad avere dei clienti? Scherzi a parte quello che bisogna fare è stare attenti a non confondere, come hanno fatto molti nei commenti del Twitter thread, “creare contenuti” con “fare SEO“: certamente le startup che vogliono essere presenti sul web hanno bisogno di contenuti per la loro comunicazione, i quali possono essere anche utilizzati per fare SEO: il problema è l’assoluta non linearità della SEO stessa.

Ci sono diversi commenti dubbiosi, tra i quali quello di Bill Slawski che dice:

Penso che forse non capisca cosa sia la SEO, perché si può permettere di pagare i click, cosa molto più facile e veloce che fare delle ricerche sulla propria audience e sviluppare una vera strategia per la SEO.

Caro Bill, stavolta penso tu non stia centrando il punto: certamente la SEO ha delle peculiarità che la rendono una strada molto interessante da seguire dalla maggior parte delle aziende, perché come dicono altri commenti è “un investimento” e perché ti porta a studiare a fondo l’audience più che i numeri e le reazioni derivate da una campagna display, ad esempio. Però i ritmi sono lenti e anche questi incerti: un sito può “esplodere” in modo repentino ed inaspettato sia in positivo che in negativo. In un mondo dove ci si aspetta una crescita a tre cifre in 12 mesi con risorse limitate la SEO non è, secondo me, tra le opzioni più interessanti.

Ora torno a fare SEO… :).

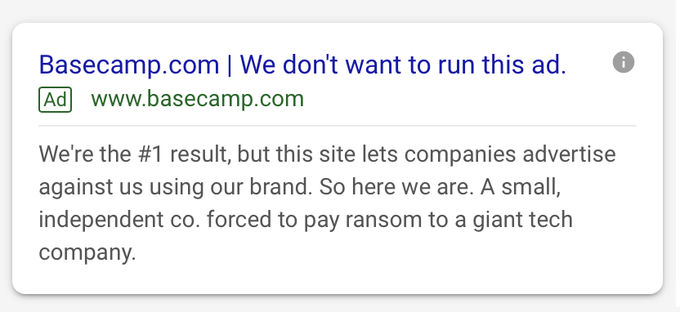

Il CEO di Basecamp si incazza (giustamente)

Il CEO di Basecamp Jason Fried ha espresso le sue “perplessità” riguardo un fenomeno molto comune ma molto triste su Google Ads, ovvero la necessità di pagare per le query relative al proprio brand name per evitare che ci si “infilino” i competitor, una pratica di fatto “condonata” da Google che lo permette e tramite la quale fa sicuramente tanti, tanti soldi. Da qualche giorno il copy per le ads di Basecamp su query brand è il seguente:

Il buon Jason si è fatto sentire fino ad arrivare a parlarne su CNBC (purtroppo il presentatore non è preparatissimo):

Il comportamento di Google, purtroppo, è piuttosto confuso e incoerente: Google ha risposto al twitter thread che “per fornire agli utenti le ads più rilevanti non abbiamo restrizioni sui termini registrati come trademark” ma, come segnalato da Fried durante l’intervista, se si prova a fare un bid per una query contenente Google si viene bloccati per “violazione del copyright”. Non male vero?

Come giustamente detto da Fried questo è un grosso problema ad esempio per le startup: chi ha più risorse può “mettersi di fronte alla porta” andando a contrastare con il semplice peso delle proprie risorse l’acquisizione di traffico di chi non ha la stessa possibilità di spesa sulle ads.

Martino Mosna, in un twitter thread sullo stesso argomento di Tim Soulo, ha detto giustamente che “è meglio dare il 2% del tuo revenue a Google che lasciare ad esempio il 15% a booking.com (rifiutandoti di presidiare le tue branded keyword con delle ads)“. Nella pratica e allo stato attuale delle cose, questo è assolutamente vero. Ma non penso sia giusto ne per le aziende ne per gli utenti. Semplicemente booking.com ne nessun altro dovrebbe poter presidiare le mie SERP brand, non è utile all’utente, che se vuole delle alternative può affinare la ricerca con la keyword “alternative” ad esempio, ne alle aziende che devono di fatto investire in queste query puramente per difesa. Gli unici a beneficiare da questa pratica sono gli azionisti di Google. Ecco un tweet che riassume brillantemente quello che penso a mia volta:

Sono anche d’accordo con Fried sul fatto che l’unica cosa che può veramente cambiare le cose è un’azione costante dell’antitrust e il legiferare dei governi: Google (e Facebook, Amazon e le altre big del settore tecnologia) esercita troppa influenza sulla vita delle persone e delle aziende per essere tratta come una qualsiasi azienda privata.

Spero intanto che il polverone alzato da questo twitter thread, il quale come hai potuto vedere ha avuto esposizione anche sui media “tradizionali” americani (i quali cavalcano molto volentieri l’onda delle questioni sulla privacy/concorrenza) possa portare ad una discussione e, chissà, ad una soluzione a quello che penso sia un vero e proprio problema.

Altri articoli interessanti

Ecco una carrellata di articoli interessanti che non ho voluto/potuto approfondire e qualche curiosità che vorrei segnalarti:

- Come riportato da questo articolo di BuzzFeed Google ha perso (poco sorprendentemente) il controllo dell’algoritmo di content suggestion di Discover, il quale ha ben pensato di offrire ad un attivista sulla questione del cambiamento climatico un articolo che lo nega come contenuto “al quale potresti essere interessato“. Il signor Tommaso Boggia, appunto il nostro attivista, non ha gradito.

Questo della “disinformazione” è un capitolo secondo me molto, molto delicato dei sistemi automatici e non di diffusione di contenuto: chi decide cosa sia la “disinformazione”? Personalmente, rendendomi conto di avere una posizione piuttosto “estrema”, non amo l’idea che chicchessia possa di fatto decidere quale sia la verità. In questo caso credo davvero si tratti di disinformazione, ma tutto questo crea precedenti piuttosto gravi. Naturalmente, senza scomodare Discover o News, anche Google Search di fatto seleziona “la verità”. Un prodotto di un’azienda privata con il potere di suggestionare l’intero pianeta. Fa paura detta così, vero? Dovrebbe. Vorrei che ci riflettessi un poco su, e che ne parlassi con le persone meno “tech” alle quali vuoi bene. Ci vuole molta preparazione per fruire in modo sano la rete Internet di oggi e di domani; - Parlando sempre dei “consigli” di Google ecco una feature da una parte molto affascinante dall’altra piuttosto preoccupante: come descritto in questo articolo sul blog “The keyword” negli USA (o con un IP USA), inserendo query quali “what to watch” Google ci farà prima allenare una intelligenza artificiale con i nostri gusti e dopo ci darà una lista di raccomandazioni con indicazioni specifiche su dove trovare i film da guardare. Da una parte una tecnologia interessante, non nuovissima di per se (Netflix, YouTube e soci lo fanno da diverso tempo) ma decisamente nuova come esperienza in SERP, dall’altra la solita raccolta dati che porta, di fatto, ad una esposizione limitata a ciò che “già ci piace”, un fenomeno che accade anche con Facebook, nel quale “viviamo” dentro un gigantesco bias cognitivo, e del quale non conosciamo ancora le vere conseguenze psicologiche e sociali, o almeno credo;

- Sai come si fa a fare una campagna di link building che raccoglie 1330 link da 134 domini differenti e fa (indirettamente?) scendere il traffico organico? Facendo arrivare i link ad una landing orfana che non passa il PageRank acquisito! Per maggiori dettagli ti rimando a questo breve articolo di Polly Pospelova che ci ricorda che SEO, diciamo, è fatta di “dettagli”;

Il pensiero della settimana

Era da diverse settimane che pensavo praticamente ogni giorno “devo pubblicare la newsletter!“, l’ho fatto sulle spiaggie dell’isola d’Elba, tra gli arbusti della Val Pusteria e nel mio “ufficio” a 1300m di quota nell’appennino modenese. Alla fine ho praticamente fatto tutto a casa mia a Modena ma penso ne sia valsa la pena attendere, che ne dici?

Per concludere voglio ringraziarti per avermi dedicato il tuo tempo leggendo fino a qui! Se è la prima volta che leggi questa newsletter e non vuoi perderti la prossima, se vuoi leggere le precedenti o più semplicemente vuoi dire la tua su quanto è stato detto non devi fare altro che scrollare ancora un pochino:

Grazie nuovamente per aver letto fin qui e ti auguro un buon proseguimento!

Petrovic dice di non essere sicuro di cosa significhi questa cosa, e sinceramente non lo sono neanche io. Queste URL hanno dei redirect 301 che non so se siano stati fatti prima o dopo l’apparizione di questi risultati. Però è una cosa bizzarra e quindi l’ho voluta inserire!

Petrovic dice di non essere sicuro di cosa significhi questa cosa, e sinceramente non lo sono neanche io. Queste URL hanno dei redirect 301 che non so se siano stati fatti prima o dopo l’apparizione di questi risultati. Però è una cosa bizzarra e quindi l’ho voluta inserire!