- Google ha implementato la “deduplication” sui featured snippet nelle SERP: il sito che vi è incluso perde il risultato organico. Molti SEO, io compreso, hanno subito pensato ad un impatto negativo su CTR e traffico. Ho fatto un po’ di ricerche, e non solo su questo aspetto;

- Sempre Google ha fatto un sacco di cose in questi giorni: rilasciato il nuovo strumento di Rimozione in Search Console, una guida per il test e il debugging dei nuovi cookies “SameSite-by-default”, e ha pure fatto arrabbiare un po’ di persone con Google My Business: a riguardo ho chiesto un commento a Luca Bove, che ringrazio già ora per averci detto qualcosa che poteva dirci solo lui con la sua grande esperienza;

- Benedict Evans, te l’avevo detto che sarebbe tornato, ha scritto un articolo molto, molto interessante riflettendo sulla vera quota di mercato di Amazon. Inoltre il CEO di Buzzfeed ha aperto una finestra sulle strategie del sito, dandoci molto sul quale riflettere;

Ciao e benvenuto alla edizione #47 della EV SEO newsletter, nella quale ho raccolto le novità e i contenuti SEO più interessanti che ho letto e selezionato per te nell’ultima settimana abbondante (dovevo finire questo nuovo contenitore, dimmi poi se ti piace!).

Si tratta anche della prima edizione che posso annunciare pubblicamente come supportata economicamente dai membri del mio Patreon, se ti viene la curiosità di saperne di più clicca sul link nel menu dopo aver letto la newsletter! Buona lettura!

Essere nello rich snippet ti esclude dai “blue link”, confermato da Danny Sullivan

Segnalato già all’inizio della settimana del 20 gennaio da diversi utenti di Fatti di SEO tra i quali Amin El Fadil, Valentina Iannaco, Fabrizio Ettori e Riccardo Perini, il fatto che l’inclusione in un rich result comporti l’esclusione dai risultati “classici” nelle SERP è stato confermato da un tweet di Danny Sullivan che traduco:

Nel caso in cui un risultato nelle SERP viene “elevato” (NOTA: usa letteralmente questo verbo) nella posizione di featured snippet non verrà più ripetuto nei risultati di ricerca. Questo cambiamento rende più ordinate le SERP e aiuta gli utenti a localizzare le informazioni rilevanti con più facilità. Il featured snippet conterà come uno dei 10 risultati che mostriamo.

Per chiarire l’ultima frase traduco quanto detto in un altro tweet sempre da Sullivan:

In presenza di un featured snippet in passato abbiamo mostrato 11 risultati, dei quali 10 unici (NOTA: perché il featured snippet veniva ripetuto in uno dei risultati). Ora invece ci saranno 10 risultati dei quali 10 unici. In caso di assenza del featured snippet i risultati rimangono 10 dei quali 10 unici, come in passato: in questo senso non è cambiato nulla. (NOTA: questo porta ad un fenomeno piuttosto simpatico che ti spiegherò tra qualche riga).

Alcuni dettagli importanti

Riguardo il rollout di questa feature:

Il rollout è avvenuto globalmente e al 100% oggi (NOTA: 22/01/2020)

Riguardo l’impatto con Search Console SearchLiaison ha pubblicato questo tweet:

Per quelli che lo chiedono, questa novità non causerà nessun cambiamento nei report di Search Console. Registriamo, a livello di pagina, solo l’istanza “più in alto” nelle SERP come sua posizione. I featured snippet erano già contati, le apparizioni duplicate non lo erano. Per maggiori informazioni: https://support.google.com/webmasters/answer/7042828

Ad un utente preoccupato riguardo l’impatto sul CTR, il quale cita il fatto che in uno studio di qualche anno fa di AHREFS nel quale i CTR dei featured snippets non sono proprio “stellari”, Sullivan risponde così:

I featured snippet portano molto traffico: proprio per questo spesso le persone ottimizzano le proprie pagine per ottenerli. Per altro tendono ad elevare pagine che solitamente sono più in basso nella pagina nella parte più alta della stessa (NOTA: non sta dicendo che lo snippet ha un impatto sui link dei risultati normali, si riferisce al fatto che nello snippet può andarci anche una pagina che non si posiziona in prima posizione). Detto questo ci sono delle opzioni che permettono a chi non vuole essere nel featured snippet di non esserci: https://support.google.com/webmasters/answer/6229325?hl=en

Dove vanno a finire i risultati organici esclusi?

Secondo questo tweet dell’account del tool Rank Ranger… scompaiono. Per giorni ho sentito colleghi affermare che i risultati organici finissero alla prima posizione della seconda pagina ma, facendo qualche rapido test, è facile vedere che non è così, e per altro non ha senso vista la struttura del sistema, il quale viene invocato anche in caso di SERP personalizzate da più di 10 risultati (delle quali non includo screenshot perché pesano parecchi kb, puoi testare tu stesso in query quali “who is stronger goku or superman“)

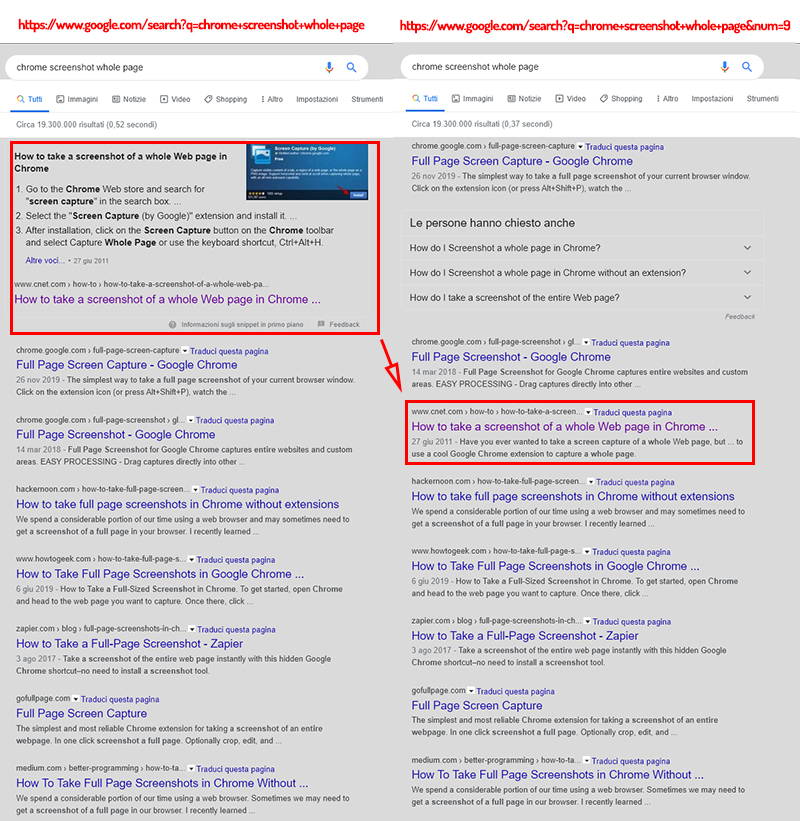

Come controllare dove si posizionerebbe un sito se si auto-escludesse dallo snippet

Nel caso, come tanti altri, tu fossi dubbioso sul fatto che sia meglio essere dentro lo snippet e volessi sapere dove saresti posizionato nel caso non vi fossi incluso per valutare una eventuale auto-esclusione, Kevin Richard ha postato un hack parecchio simpatico con il quale determinare quale posizione si occuperebbe in SERP se il proprio sito che si posiziona nel featured snippet perdesse questa feature o si decidesse di fare l’opt-out via codice.

Per fare ciò basta inserire la stringa “&num=9” in coda all’URL della query: forzando la SERP ad avere 9 risultati il sistema che genera lo snippet, che funziona con almeno 10 risultati in SERP, viene disattivato.

Prendiamo da esempio la query “chrome screenshot whole page” (un esempio di keywordese!):

NOTA: lo sfondo delle SERP è grigio perché nel mio browser “principale” ho modificato i css delle pagine troppo bianche per stancarmi meno gli occhi, fai finta che sia bianco!

Una soluzione semplice da applicare ma non facilissima da intuire, bravo signor Richard.

Come auto-escludersi dallo snippet

Osservazione numero 1: gli snippet sono di un formato consolidato e “positivo” per quanto riguarda la visibilità del sito dal quale vengono presi i dati

Inoltre mentre cercavo di testare questo hack ho notato una cosa: tutti gli snippet generati sono del tipo “Snippet di testo” + “URL” + “Title grande quanto un blue link cliccabile” aventi come unica variabile la presenza di un’immagine, un’ottima notizia rispetto ai classici snippet con il link alla pagina con un font-size minuscolo posti in basso a destra dello snippet stesso.

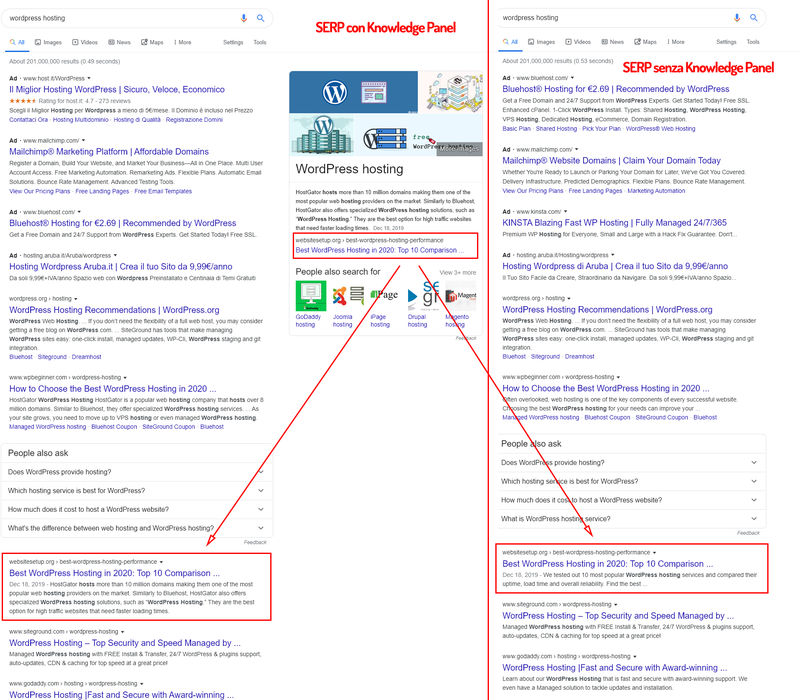

Rispondendo ad un tweet di Glenn Gable che fa notare che gli snippet “people also ask” non sembrano essere toccati dall’update, un ragazzo di nome Ross Winn ha segnalato che secondo lui il risultato organico scompare anche con il Knowledge Graph (o lo pseudo tale) e non solo con il featured snippet. Utilizzando google.com e la medesima la query (e l’hack per l’esclusione), personalmente, ottengo questo risultato:

Molto interessante notare che l’inclusione nello pseudo Knowledge Panel fa cambiare la meta description, lunga in modo inusuale e riportante lo stesso testo dello pseudo Knowledge Panel.

Detto questo mi sorge un dubbio: si tratta di un caso specifico dove Google ha “corretto il tiro“? Ho provato a cercare un’altra query che mi desse quello strano Knowledge Panel, che proprio Knowledge Panel non è, ma ho ottenuto solo risultati di pannelli che stampavano dati da Wikipedia, che risultava come primo risultato. Se ti vengono in mente altre query fammi sapere!

Gli utenti identificano correttamente i featured snippet?

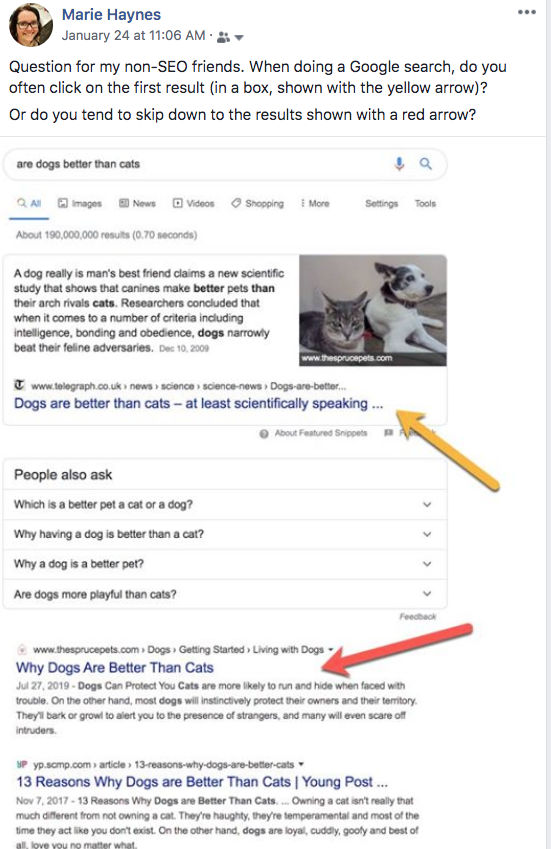

Tornando all’argomento featured snippet secondo questo tweet di Marie Haynes però c’è un problema nel ragionamento “lo facciamo per gli utenti” di Google, ovvero che questo tipo di snippet tende a far credere alle persone che si tratti di una pubblicità: la Haynes ha chiesto attraverso uno screenshot ai suoi contatti su Facebook (secondo lei persone tra i 40 e i 60 anni, con qualche eccezione verso i 30, non particolarmente edotti per quanto riguarda il web) se, facendo una ricerca su Google, tendessero a cliccare sul primo risultato, ovvero sullo snippet, o se tendessero a scrollare la pagina. Ecco lo screenshot in questione:

La Haynes riporta (trovi gli screenshot su Twitter) che diverse persone hanno risposto “non clicco sulle ads/sulle cose sponsorizzate“, asserendo di fatto di aver percepito lo snippet come un’unità pubblicitaria. Naturalmente questo “risultato” è poco più di una suggestione:

- non è un test svolto con rigore scientifico: come hanno risposto alcuni utenti su Twitter “le persone mentono” e andrebbero osservate mentre utilizzano le SERP oltre ad ascoltare il loro feedback (cosa che Google fa raccogliendo dati);

- se tutti fossero davvero così coscienziosi sul fatto di cliccare sulle pubblicità, Google non fatturerebbe miliardi di dollari con le pubblicità in SERP;

- il campione in esame, per quanto riguarda l’età, non è ideale: mancano tutti i giovani e i giovanissimi, i quali sospetto potrebbero essere i maggiori “cliccatori” di unità pubblicitarie e, secondo questo studio di Lily Ray per Moz rilasciato nell’aprile 2019, tendono a “considerare la loro domanda come avente risposta senza cliccare sullo snippet o altri risultati” (e ci sarebbe da discutere anche a “livello sociale” su questo fatto, ma non è questo lo spazio adatto);

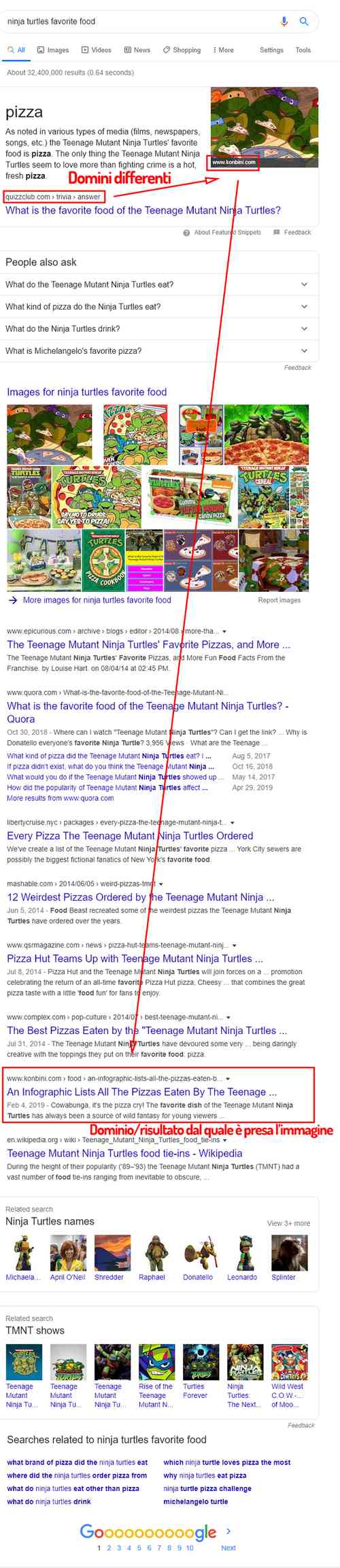

Osservazione numero 2: Google continua a prendere le immagini da domini diversi da quello dal quale prende il testo per lo snippet

Da notare, sia nell’esempio della Haynes che in un piccolo e personale test, svolto con la prima query che mi è venuta in mente (la vedrai tra poco), Google continua potenzialmente ad utilizzare nel featured snippet un’immagine proveniente da un altro dominio, una bruttissima “abitudine” che a quanto pare l’azienda non ha intenzione di modificare molto presto, visto che si tratta di una lamentela vera e propria e reiterata nel tempo (mi scuso ma non ho il tempo di recuperarne di specifici per farteli vedere), al contrario della “duplicazione in SERP” che questo update dovrebbe risolvere.(NOTA: in realtà mentre davo un’ultima controllata prima di finire la newsletter ho trovato questo articolo di seoroundtable.com dove Danny Sullivan dice che “sta spingendo per correggere questo errore”, vedremo!). Ecco l’aulico esempio:

Osservazione numero 3: se si inibisce la generazione del featured snippet si perdono anche i risultati vocali

Rispondendo ad una domanda piuttosto arguta di Jeff Russel su Twitter Danny Sullivan ha detto una cosa molto interessante:

Se una risposta vocale viene generata da un featured snippet (NOTA: ovvero se la risposta vocale ad una query è una “lettura” del featured snippet”) e questo featured snippet viene inibito dal webmaster del sito dal quale viene generato il featured snippet, viene di fatto anche inibito il suo essere la risposta vocale.

In buona sostanza beh, bisogna fare parecchie considerazioni prima di usare il “nosnippet” (documentazione relativa qui: https://support.google.com/webmasters/answer/6229325?hl=it ).

Detto questo domani esce la newsletter nuova con uno “speciale” sui featured snippet nel caso tu abbia qualche dubbio, ho cercato di andare il più possibile a fondo sulla questione!

Alcune analisi di colleghi sul fenomeno

In questi ultimi giorni sono uscite un paio di analisi interessanti su questo update delle SERP.

La prima è stata pubblicata da Kevin Indig sul suo blog e si fonda sulla domanda “essere solamente dentro il featured snippet farà calare il tuo traffico?“. Vorrei partire che la sua conclusione è un deciso no.

I dati, molto ben definiti e interessanti (Kevin descrive in modo piuttosto preciso la metodologia di raccolta dati) mostrano per il sito dell’azienda del quale è vice presidente, www.g2.com, un netto aumento del CTR da desktop e un modesto aumento di traffico, a fronte di un calo di CTR e traffico da mobile. La cosa chiara è che i featured snippet desktop e mobile possono servire intenti molto differenti, con impatti molto differenti sul CTR (anche a causa delle differenti tipologie di featured snippet). Citando l’articolo:

Alcune conclusioni di questa analisi mi portano a credere che Google abbia raggiunto un livello di comprensione che gli permette di servire con più sicurezza intenti di ricerca differenti tra mobile e desktop.

Per conoscere i risultati dell’analisi nel dettaglio ti rimando alla lettura dell’articolo stesso.

La seconda analisi è stata pubblicata da Derek Gleason su cxl.com, il quale ha analizzato il traffico di Wikipedia (con i dati scaricabili dalle sue API, non lo sapevo!) e ha scoperto, con buona approssimazione, che il sito ha perso un po’ di traffico, circa il 6,89% sulle pagine analizzate con lo snippet e di media intorno al 1,69% del traffico per pagina. Anche qui ci sono state delle conclusioni interessanti:

- la prima, presa da un arguto tweet di Bill Slawski, è che questo update da tutto un altro sapore alla cannibalizzazione delle query tra pagine: se due pagine si posizionano per le stesse query ma solo una viene tolta dalle SERP da problema la cannibalizzazione diventa un fenomeno interessante. Un’idea affascinante;

- la seconda è che se anche eri secondo nella SERP per una specifica query e la pagina in prima posizione aveva anche il featured snippet non pensare di ottenere un grande aumento di traffico: la tua pagina rimarrà assai poco visibile, tendenzialmente under the fold;

Complimenti ai colleghi per i due articoli molto interessanti, che ti consiglio di leggere nella loro forma originale.

Conclusioni

Personalmente non ho ancora avuto notizia di drastici cali di traffico dovuti all’update, né da parte di clienti né da parte di colleghi né tantomeno su miei progetti (se a te è successo, se ti va, contattami: mi piacerebbe saperne di più!). Come al solito mi limiterò, per ora, a pazientare: penso sia presto per trarre conclusioni generalizzate e, come in molte cose della SEO, penso sia il caso di osservare con molta attenzione le singole query e le singole nicchie per determinare, ad esempio, sia il caso o no di inibire l’entrata delle proprie pagine web nei featured snippet. Sinceramente penso già da ora che sarà difficile che lo sia, come penso in buona sostanza affermi anche Rand Fishkin in questo tweet citato nell’analisi di Derek Gleason:

Puoi decidere se ottenere il posizionamento nel featured snippet (ma non il traffico), o lasciarlo ottenere da qualcun altro. Penso che la SEO in-SERP sarà una parte molto importante nel web marketing del futuro

Per concludere ti lascio con una riflessione di AJ Kohn:

Stavo pensando: se l’eliminazione della duplicazione tra il featured snippet e il risultato organico aiuta l’utente rendendo più ordinati i risultati di ricerca non è che eliminando la duplicazione tra risultati organici e risultati paid si potrebbe fare essenzialmente la stessa cosa?

Direi che l’ha appoggiata piano.

PS: anche Bill Slawski, in uno slancio ironico piuttosto inconsueto (almeno per quanto riguarda la sua presenza sul web), ne ha detta una divertente citando la mitica Marie Kondo:

Non è che Google si sta muovendo nel business dei “personal home organizer” riordinando le SERP e cercando i risultati che “sprizzano gioia”?

Altre news e articoli SEO

Ecco altre news e articoli interessanti dal mondo della SEO:

Google rilascia un “nuovo” (e deludente) strumento di rimozione su Google Search Console

Il 28 gennaio Google ha annunciato sul Webmaster Central Blog di aver reso disponibile in Search Console un nuovo strumento per la rimozione di contenuti dall’indice. Personalmente, da grande appassionato di cancellazione di URL e pulizia del crawling mi ero emozionato: purtroppo le mie aspettative sono state disattese. Vedendo i primi screenshot pensavo ci fosse finalmente il modo di rimuovere URL in modo non solo temporaneo ma definitivo (cosa che si può fare seguendo questa mia guida) e invece il tool di compone in questo modo:

- Temporary removals: come nella vecchia Search Console questo tool nasconde dalle SERP il contenuto per 6 mesi, senza rimuoverlo veramente. Inoltre cancella la cache di Google e rimuove la meta description dai risultati di ricerca fino a che Googlebot non tornerà a scansionare la URL. Con il passaggio piuttosto ambiguo sulla meta description, che ho riportato fedelmente dall’articolo di Google, penso si intenda che dovrà venire riconsiderata una volta finita l’esclusione temporanea;

- Outdated content: questa sezione non è, purtroppo, quella prefissa alla rimozione vera e propria dei contenuti, ma si limita solamente a riportare le richieste di rimozione di contenuti obsoleti dal proprio segnalate da terzi tramite il “remove outdate content tool” secondo le linee guida di questa pagina. Può essere un dato interessante ma speravo fosse un tool vero e proprio;

- SafeSearch filtering: ecco questo è già più interessante in quanto riporta la lista delle pagine riportate dagli utenti come “contenuto per adulti” attraverso il “SafeSearch Suggestion tool“. Sono andato a controllare su alcuni clienti che potenzialmente potevano ricevere tali segnalazioni ma non ne ho trovata neanche una. Probabilmente su siti italiani si troverà molto poco. Sicuramente può essere un tool utile, soprattutto in caso di strani cali di traffico. Una inclusione intelligente;

E questo è quanto. Capisco il perché Google non metta a disposizione “l’opzione nucleare“, visto il male che a volte si fanno gli utenti meno attenti già solamente con la rimozione temporanea, ma questa volta, sinceramente, mi ero proprio illuso. Comunque sia un piccolo passo avanti è stato fatto, me lo farò bastare!

Google rilascia una guida al test e al debugging del nuovo sistema “SameSite-by-default” dei cookies

Facendola molto breve: la guida per il debugging relativo al nuovo comportamento di Chrome riguardo i cookies (per i dettagli ti rimando alla scorsa newsletter) si trova su questa pagina. La appoggio qui per gli sviluppatori che leggono la newsletter o agli amici sviluppatori degli altri lettori (che dovrebbero invitarli ad iscriversi!).

In alternativa J.R. Oakes di Locomotive Agency ha scritto un breve articolo tramite il quale rilevare e affrontare eventuali problemi che potrebbero sorgere per i cookies del tuo sito. Visto che mi pare più semplice e comprensibile dei documenti di Google te lo segnalo.

Per altro potrebbe essere un ottimo argomento per una bella guida approfondita in italiano per la quale ricevere i mitici link spontanei, che, ohibò, esistono davvero (tutte le mie guide ne hanno ricevuti ad esempio). Se qualcuno all’ascolto la scrivesse beh, un link lo prenderebbe almeno dalla mia newsletter, quindi se decidi di scriverla fammelo sapere!

DuckDuckGo fa la sua proposta riguardo la schermata di selezione del motore di ricerca di default di Android

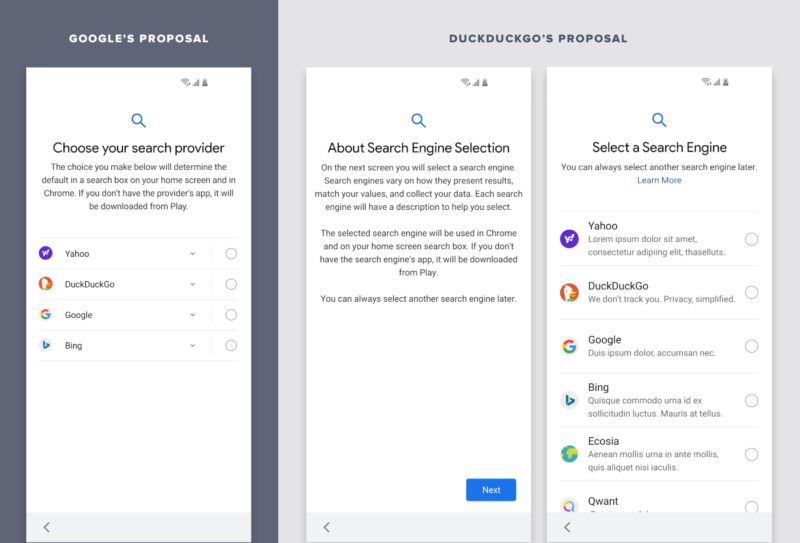

Ricordi quando ti dicevo che DuckDuckGo si è aggiudicata l’asta per essere tra le scelte della schermata di selezione del motore di ricerca di default che Google, costretta dall’Antitrust, dovrà implementare su Android in Europa?

Ebbene secondo searchengineland.com DuckDuckGo ha proposto (tramite questo articolo sul loro blog) un formato diverso di questa schermata, obiettivamente molto più chiaro sia a livello di copy che grafico. Per intenderci ecco lo screenshot con una comparazione:

Traducendo e riassumendo le proposte:

- I consumatori dovrebbero avere più di 4 proposte: tutti sanno che sugli schermi moderni si può effettuare lo scroll. DuckDuckGo accusa via Twitter Google di “limitare artificialmente gli slot” tramite il modello ad asta utilizzato per assegnarli (recupera la precedente newsletter per saperne di più;

- I consumatori dovrebbero avere una schermata introduttiva: serve per far capire il peso della scelta all’utente. Trovo abbastanza brutta la presa di posizione implicita di Google non inserendo una cosa del genere;

- I consumatori dovrebbero essere assicurati sul fatto di non essere permanentemente legati alla scelta compiuta: secondo DuckDuckGo l’inserimento della frase “Puoi sempre scegliere un altro motore di ricerca più tardi” ha incrementato in modo sostanziale l’adozione di motori di ricerca non Google, di fatto lo sperimentare qualcosa di diverso;

- Si dovrebbe parlare di “Search Engine” e non di “Search Provider”: anche in questo caso è chiara la strategia comunicativa, o anzi non-comunicativa, di Google in proposito;

- Si dovrebbe parlare di “un motore di ricerca” e non del “tuo motore di ricerca”: anche questa scelta di Google fa leva su di un bias cognitivo che, se vogliamo dare “peso” a questa scelta, non deve esserci;

- Il consumatore dovrebbe leggere un testo conciso, senza concetti confusionari o allarmanti: DuckDuckGo critica il fatto che venga citato Chrome, in quanto il suo rapporto con Google Search influirebbe sulla scelta, e che venga specificato che ci sarà la “scocciatura” di scaricare una ulteriore app nativa. Di fatto la frase è giusta perché, ingiustamente, Google Search è già pre-installato;

- I consumatori dovrebbero vedere loghi più grandi;

- I consumatori dovrebbero vedere le descrizioni dei motori di ricerca da subito: la proposta di DuckDuckGo è una descrizione più breve ma che sia automaticamente mostrata a schermo. Google sa benissimo che l’utente medio, con quel tipo di UX, non leggerà mai le descrizioni e non verrà mai ad esempio incuriosito da un “motore di ricerca che non ti traccia“;

Tutte proposte piene di senso, secondo me. Naturalmente è molto difficile che queste vengano accolte ma DuckDuckGo si muove estremamente bene a livello comunicativo e ultimamente “farsi sentire” ha portato a risultati molto interessanti in giro per il mondo, secondo me potrà quantomeno smuovere le acque. Sono oltre il “budget di tempo” per la newsletter ma ci tenevo proprio a parlarti di questa cosa molto importante, sulla quale spero vorrai confrontarti con chi ti è vicino, dal “digitalmente educato” al parente meno attento a questo mondo alle prese con il nuovo telefono.

Google stringe le maglie sullo spam sulla piattaforma Google My Business (parola di Luca Bove!)

Con un tweet sibilino Austing Holdsworth ha acceso una discussione nella community SEO internazionale riguardo una nuova ondata di sospensioni di schede Google My Business incuriosito mi sono rivolto a Luca Bove di localstrategy.it, esperto e sempre sul pezzo riguardo le questioni local SEO. Chiedendo lumi sulla vicenda Luca mi ha detto questo:

Dopo la strigliata del Wall Street Journal Google ha cominciato a prendere davvero seriamente il problema dello SPAM sulle sue mappe,

Come Product Expert sono stato a Berlino ad Ottobre, e 2 interventi su 3 da parte dei googler sono stati su come stanno combattendo lo spam. Stanno investendo soldi, tecnologie e ci hanno messo su molte persone. Forse non ancora sufficienti, ma tante.

L’approccio di Google su GMB è il solito preso contro lo spam sull’indice principale: costruire algoritmi capaci a scovare tutte le violazioni delle policy.

Questi algoritmi sono basati sull’intelligenza artificiale e da qualche mese fanno fuori un sacco di roba: recensioni false, foto non corrette, o cancellano direttamente le schede che ritengono fasulle. Stanno anche cercando di prendere provvedimenti contro singoli utenti, che infatti dall’app (e solo dall’app) possono essere segnalati.

Il problema è che questo algoritmo non ha ancora raggiunto la massima efficienza e ci sono un sacco di falsi positivi. Tra tanto spam, butta fuori anche roba buona. Sul forum di assistenza ci sono molti post su recensioni reali cancellate, foto non caricate e roba simile. Lo devono ancora addestrare per bene.

(NOTA: ometto una parte “privata” della conversazione) sta cercando di combatterlo seriamente lo spam sulle mappe. Non so se sia una mia impressione, ma mi sembrano più pulite di prima ora.

Personalmente, anche se non riesco a dire “l’ho notato anche io” per la mia attuale mancanza di progetti 100% local non ho motivo di dubitare dell’esperienza di Luca, che di fatto suffraga quanto discusso online. Vedremo se Google avrà qualcosa da dire tramite i suoi canali ufficiali in futuro.

Google e il meta tag “unavailable_after“

In un recente hangout sul canale Google Webmaster John Mueller ha dichiarato che Google onora ancora il meta tag “unavailable_after“, il quale è stato introdotto nel 2007 e (citando la documentazione ufficiale) “consente di specificare l’ora e la data esatte in cui interrompere la scansione e l’indicizzazione della pagina“. Ecco un esempio di implementazione (preso da un’altra pagina della documentazione di Google):

<meta name="robots" content="unavailable_after: Sunday, 01-Sep-24 01:00:00 PDT">

Quello che la documentazione non dice è che Google, una volta “preso nota” di questa indicazione vorrà verificare che la pagina, dopo la data indicata, non sia più disponibile: lo farà scansionandola dopo la data segnalata e aspettandosi una risposta 404 o un noindex.

Personalmente è un meta tag che non mi è mai capitato di vedere o utilizzare ma può essere molto utile su listing o news. Beh, ora lo conosci anche tu (o forse lo conoscevi già e non me l’avevi detto, potevi dirmi qualcosa!).

Rilasciato schema.org 6.0

Come riportato da un articolo sul nuovo blog di Aaron Bradley il 22 gennaio è stato rilasciata la versione 6.0 di schema.org. Tra le novità riportate da Bradley particolarmente interessanti per la SEO segnalerei:

- Aggiunge delle proprietà interessanti, quali “numberOfFullBathrooms” e “yearBuilt” alle “Accomodation“, ovvero i dati strutturati relativi alle unità immobiliari.

- Il termine “Guide“ per i “CreativeWork“, ovvero “una pagina o un articolo che raccomandano specifici prodotti o servizi o che parlano di specifici aspetti da considerare su qualcosa di specifico“;

Come riporta Bradley puoi trovare le note di rilascio complete su Github.

La SEO su YouTube non riguarda la ricerca su YouTube?

Seppur relativamente semplice questa trascrizione del video di Luke Sherran per SemRush chiamato “YouTube SEO in 2020” contiene alcune nozioni che vorrei condividere con te:

- Su YouTube il traffico organico del motore di ricerca interno rappresenta, relativamente, solo una piccola frazione del traffico totale verso i video di un canale (nell’esempio di Sherran il 20%);

- Quello che conta sono le metriche relative al comportamento degli utenti:

- CTR (Click Through Rate);

- Tempo di visualizzazione (watch time);

- Percentuale di visualizzazione;

- Il CTR è uno degli elementi principali del sistema chiamato “collaborative filtering“, ovvero il filtraggio dei video suggeriti nei vari spazi di YouTube attraverso la “selezione” fatta dal comportamento di utenti con un profilo (basato su dati demografici e altri fattori) simile a quello dell’utente per il quale vorrebbe “consigliare” dei video;

- Per influenzare il CTR l’elemento chiave sono le thumbnail, le quali però vengono solitamente snobbate dai content creator. Personalmente anche io, come nel suo esempio, le credo durante l’esportazione del video (anche se mi sono venute un paio di idee!). C’è un bell’esempio sul post;

Le considerazioni sul tempo e sulla percentuale di visualizzazione sono forse un po’ meno interessanti, nel senso che persone come Giorgio Tave hanno già discusso questo tipo di dettagli in modo più approfondito: lascio a te decidere se andare comunque a leggerle nella trascrizione del video di Sherran.

Google sta creando il Tik Tok per adulti (e preparandosi ad un nuovo rich snippet)?

Purtroppo non è disponibile in Italia ma il laboratorio “Area 120” di Google sta sviluppando una applicazione, chiamata Tangi, pensata per condividere brevi video tutorial di 60 secondi sul DYI, “do it yourself” ovvero sul “fai da te”.

Se prendesse piede sarebbe un’ottima candidata per uno snippet dedicato in SERP, non trovi? Pensaci:

- saprebbe già che sono video brevi, e quindi non ha bisogno di estrapolare risposte brevi da lunghi video di YouTube;

- potrebbe vedere se una risposta è valida o meno dalle statistiche di visualizzazione e il sentiment dei commenti;

- potrebbe individuare content creator strategici da premiare e quindi utilizzare per le risposte in nicchie specifiche;

Google sa bene che il lavoro “manuale” è meglio farlo fare agli altri, ne sappiamo qualcosa no? Non dire che non ti avevo avvertito!

(NOTA: proprio mentre preparavo il sommario per la newsletter Giorgio Tave ha dedicato una parte del tuo ultimo video sull’argomento: lo trovi qui)

Internet nell’orbita della SEO

Ecco una carrellata di articoli interessanti che vorrei segnalarti:

Amazon ha il 35% del mercato o il 5% del mercato?

Recupero questo interessantissimo articolo di Benedict Evans pubblicato il 19 dicembre perché penso sia da leggere. Di fatto si tratta di un’analisi dei numeri veri e propri di Amazon, analizzando i dati e superando le “sensazioni” per riflettere sull’idea che Amazon possa rappresentare un “monopolio”. Riassumo alcuni punti chiave:

- Amazon, sul totale stimato di 522 miliardi di dollari di vendite nel mercato e-commerce americano nel 2018, ha fatturato 184 miliardi ovvero il 35% del totale, percentuale però da dividere in:

- 15% di vendite first party, ovvero di prodotti venduti direttamente da Amazon dal prezzo da lei determinato;

- 20% di vendite third party, ovvero di soggetti terzi che vendono attraverso Amazon (e che competono, a livello di prezzi, con i prodotti venduti da Amazon);

- Amazon però, se parliamo di vendita al dettaglio, non compete solamente con gli altri e-commerce: compete con i negozi fisici per questo mercato il quale, secondo le stime di Evans, ha mosso 3600 miliardi di miliardi di dollari. Amazon, con una fatturato stimato di 200 miliardi di dollari (i 16 miliardi in più vengono dai negozi fisici sul suolo americano), ha rappresentato circa il 6% di questo mercato nel 2018;

- Nel 2018 Walmart, per intenderci una grande catena di “supermercati” americana, ha fatturato 318,5 miliardi di dollari, più del 150% di Amazon;

- Per capire se Amazon sia davvero in odore di monopolio bisogna però andare ancora più a fondo andando a ragionare sulle quote di mercato relative a specifici segmenti, andando a definire quindi, di fatto, specifici mercati: in questo caso i numeri più alti li ha nel suo vecchio core business, ovvero quello dei libri, sia quelli stampati (più del 50%) che quelli digitali (almeno il 75%);

- Anche se Amazon cresce insieme alla percentuale del mercato di vendita al dettaglio “inglobata” dagli e-commerce, e che quindi possedendo già una buona fetta del mercato e-commerce stesso (35-40%) significa che diventa sempre più preponderante proprio sulla vendita dettaglio, la sua diffusione non è destinata a crescere in modo sempre lineare: nel tempo sono sorti e sorgeranno nuovi modelli di business come Shopify, che nel giro di 5 anni è arrivata a fatturare 60 miliardi dollari dal nulla.

- Queste aziende sono in grado di insinuarsi perché, di fatto, Amazon ha il problema di avere un modello pre-determinato tramite il quale fare business, pensando all’esperienza sulle sue properties web, e difficilmente riuscirà a discostarsi da esso per aggiungere nuovi modelli di business al suo interno;

- Teniamo a mente anche l’esperienza dei supermercati che, come possono testimoniare i nostri genitori e i nostri nonni, avrebbero dovuto far cessare di esistere i negozi “classici”: non ci sono riusciti;

Devo dire che è sempre un piacere leggere Evans e “rinfrescare la mente” dagli eco di quei pensieri universalmente accettati (o giù di li) come “Amazon si mangerà tutto” e che, pur essendo “comodi” da sfoggiare in una conversazione, spesso propugnano idee non propriamente aderenti alla realtà dei fatti.

A proposito di “adattarsi per sopravvivere al web“: il CEO di BuzzFeed riflette ad alta voce sul 2020

L’articolo pubblicato dal CEO e founder di BuzzFeed Jonah Peretti è un contenuto che spero possa farti riflettere:

- L’azienda ha saputo evolversi da un modello di business basato sul native advertising ad un assetto di monetizzazione nel quale il 70% del revenue viene da fonti alternative;

- La piattaforma sta abbracciando il modello del revenue sharing in quanto nei digital media si è passati da strutture basate sull’acquisizione di capitale a strutture che questi soldi li devono “generare”;

- L’azienda misura, per ogni contenuto, “quanto costa, quante persone raggiunge e quanto revenue genera“, in modo da creare un circolo virtuoso tramite il quale produrre più contenuti, raggiungere più persone e generare ancora più revenue;

- Tramite questo approccio data-driven ogni team relativo a specifici segmenti di contenuto, a per le news, è profittevole;

- BuzzFeed ha preso e vuole prendere sempre di più il controllo delle transazioni dirette, diventando non solo una piattaforma di discovery di prodotti/esperienze ma andando, attraverso delle partnership, ad offrire subito dopo la fruizione dei propri contenuti questi prodotti/esperienze e tagliando fuori i buffer classici, ovvero Google e i siti che vendono attraverso di esso;

Oltre a queste, che sono forse le riflessioni più interessanti per i miei lettori, ne vengono citate altre sul ruolo di BuzzeFeed nel futuro della televisione, del “paid social” e del giornalismo digitale che non tratterò in questa newsletter ma che ti invito a leggere. Questo è un articolo scritto, probabilmente, per attirare investitori ma rappresenta un documento interessante per chi fa impresa sul web. Per altro si ricollega molto bene alla nuova SEOttimana che ho girato ormai 10 giorni fa ma che, quando pubblicherò nei prossimi giorni, spero vorrai guardare (la trovi sul mio canale YouTube).

Google implementa un SOS Alert per il Coronavirus 2019

Dal 30 di gennaio Google, secondo quanto riportato in questo Twitter thread, Google ha implementato uno speciale “SOS alert” per il Coronavirus 2019-nCoV, di fatto creando una SERP completamente personalizzata above-the-fold, dove l’azienda ha voluto riportare fonti autorevoli sulla questione e risorse utili. Un’iniziativa secondo me giusta e che può darci un’idea delle SERP mediche del futuro: saranno sempre più verticalizzate su fonti che riterrà attendibili. Nel mentre meglio lavarsi spesso le mani.

Il pensiero della settimana

Mentre sto scrivendo queste ultime righe vengo da due giorni (una domenica e un lunedì) di lavoro piuttosto intenso su questa nuova piattaforma, evxp.it, che presenterò in modo più “strutturato” nelle prossime settimane: per ora ti lascio “curiosare” in giro (troverai tutti i contenuti SEO che ho pubblicato in questi anni, anzi non proprio tutti perché devo finire di integrarli ma sono già tantissimi!).

Per altro, come dicevo nell’introduzione, posso (finalmente) dire in pubblico che questa newsletter è stata resa possibile dal supporto dei membri del mio Patreon, una piattaforma di crowdfunding attraverso la quale vorrei finanziare la creazione dei miei contenuti. E quindi grazie a:

- Carlo

- Cristina

- Fabrizio

- Gianni

- Luca

- Marcello

- Maurizio

- Roberto

- Salvatore

- Simone

Che nomino con il solo nome di battesimo perché non trovo il file dove mi avevano indicato la loro preferenza riguardo all’essere o meno nominati in questi frangenti: chiedo venia! Nel caso tu sia interessato a capire di che cosa si tratta (e cosa c’è sul piatto per te) puoi visitare il mio profilo sulla piattaforma.

Per concludere voglio ringraziarti per avermi dedicato il tuo tempo leggendo fino a qui! Se è la prima volta che leggi questa newsletter e non vuoi perderti la prossima, se vuoi leggere le precedenti o più semplicemente vuoi dire la tua su quanto è stato detto non devi fare altro che scrollare ancora un pochino:

Grazie nuovamente per aver letto fin qui e ti auguro un buon proseguimento!